In diesem Realitäts Check zeige ich aus aktuellem Anlass auf, wieso ChatGPT öfters einmal schummelt und worauf bei einem Einsatz geachtet werden muss.

«HERMES steht für “Hermes Methoden-Sets”. Es handelt sich um eine Projektmanagement-Methode, die von der Schweizer Bundesverwaltung entwickelt wurde. Der Name “HERMES” wurde gewählt, um den griechischen Gott Hermes zu symbolisieren, der in der Mythologie als Bote der Götter und Vermittler zwischen den Welten gilt.»

Wie bitte? Eine tolle Geschichte, leider total falsch … Die Wahrheit ist mit dem «Handbuch der Elektronischen Rechenzentren des Bundes, eine Methode zur Entwicklung von Systemen» leider deutlich langweiliger und wenig mythologisch. Virtuell gelb anstreichen und weiterlesen …

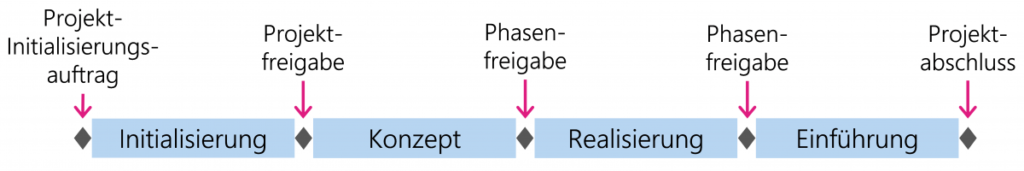

«Die Hermes Phasen sind: Initialisierung, Konzeption, Realisierung, Einführung, Abschluss»

Klingt toll, ist nur leider ebenfalls falsch. Hermes kennt im Gegensatz zu anderen Projektmanagement-Methoden zwar einen Meilenstein namens Projektabschluss, es gibt jedoch keine Abschlussphase. Der Projektabschluss wird in der Einführung vorbereitet, das reicht dann auch.

Zusätzlich irritiert mich, dass im späteren Text immer wieder von einer Initiierungsphase gesprochen wird, die nun halt in Hermes-Sprache klar definiert Initialisierung heisst. Die Konzeptphase heisst wiederum im Standard schlicht Konzept und nicht Konzeption.

Dieses Wissen lässt sich innert Minuten auf der öffentlichen Hermes-Webseite nachlesen und darf sogar, unter Quellenangabe, plagiatsstraffrei in jede Arbeit kopiert werden.

Spätestens jetzt ist klar: Hier wurde ein fortgeschrittenes Sprachmodell genutzt, welches auf Deep Learning basiert, der breiten Masse inzwischen schlicht und einfach als ChatGPT bekannt.

Bevor man ChatGPT im Alltag anwirft, hilft es zu verstehen, wie diese KI grob funktioniert und wieso obige Resultate durchaus logisch erklärbar sind.

ChatGPT besteht grob aus zwei Teilen, einem Chatbot (Frontend), welcher Anfragen entgegennimmt und mit einem riesigen vortrainierten Sprachmodell (Backend) verbunden ist. Das Sprachmodell wiederum kann man sich wie ein riesiges (neuronales) Netz aus Wörtern vorstellen, die semantisch, kontextuell basierend auf Milliarden von Daten miteinander verbunden wurden. Dieser Teil wurde, teilweise mit menschlicher Unterstützung (supervised), vortrainiert.

Die KI merkt sich Muster und Strukturen der menschlichen Sprache. Sie rechnet immer die Wahrscheinlichkeit des nächsten Wortes aus und generiert so Wort für Wort ziemlich schnell plausibel klingende Sätze.

Was könnten die Ursachen für obige Resultate sein …

Problem 1: Wahrscheinlichkeit

Hermes ist ein bekannter Begriff der Mythologie, das dahinterliegende Sprachmodell dürfte x-tausend vernetzte Trainingsdaten zu diesem Begriff haben. Die mathematische Wahrscheinlichkeit, dass die Begriffe eine Beziehung zueinander aufweisen, erscheint ohne tieferes kontextuelles Verständnis auch für einen Menschen auf den ersten Blick plausibel.

Fakt ist … Die Hermes-Projektmanagement-Methode wurde entwickelt, um Projekte im Bundesumfeld professioneller abwickeln zu können. Der mythologische Hermes und Seelenführer könnte sie höchstens zum Projekttod begleiten.

ChatGPT fehlt aktuell sowohl die Fähigkeit kritischen Denkens als auch der Reflexion. Eine Beziehung zur Mythologie hat ChatGPT unkritisch und rein auf datenbasierter Wahrscheinlichkeit erfunden.

Problem 2: Zu kleines Datenset / die Masse bestimmt

Verfügbare Informationen zur Hermes-Projektmanagement-Methode sind nur in kleiner Zahl und primär in der Schweiz verfügbar. Im Vergleich zu den weltweit dominierenden Projektmanagement-Methoden ist Hermes genauer und strikter definiert.

Im trainierten Sprachmodell steht die Hermes-Methode vermutlich im gleichen Raum des neuronalen Netzwerks wie Millionen von anderen Texten, Büchern, Artikeln rund um Projektmanagement. Viele der internationalen Methoden kennen tatsächlich eine Abschlussphase.

Da das spezifische Datenset zu Hermes im Sprachmodell bestimmt winzig klein ist, folgt aufgrund nicht signifikanter Stichprobengrösse (fehlende Masse an Trainingsdaten) folgende Logik: Wenn die Mehrheit der Projektmanagement-Methoden eine Abschlussphase kennt, wird dies bei Hermes sicher auch so sein. Wieso sollten die Schweizer dies auch anders handhaben als der Rest der Welt?

Problem 3: Aktualität und fehlender echter Quellenbezug

Das dahinterliegende Sprachmodell kennt nur Informationen, die vor September 2021 publiziert wurden. Informationen zum aktuellen Hermes 2022 Standard kann es schlicht noch gar nicht kennen. Ausserdem hat das trainierte Sprachmodell Stand heute nicht über Referenzpunkte zu den ursprünglichen Quellen. Es weiss schlicht nicht, woher es die Trainingsdaten ursprünglich hatte.

Die aktuellen Grenzen von ChatGPT

ChatGPT liefert Stand heute nur gute Resultate, wenn AnwenderInnen:

- sich bewährte Praktiken zum Fütterungsverhalten (gute Prompts) angeeignet haben.

- Dinge abfragen, über die vor September 2021 viel geschrieben wurde.

- verstehen, dass Wahrscheinlichkeit nicht immer ein guter Berater ist.

- erhaltene Resultate auf tatsächliche Faktenlage und Wissenschaftlichkeit hin überprüfen.

ChatGPT macht Spass und ist ein mächtiges Werkzeug für Ideation, kann bei Recherche unterstützen und ist ein mächtiger und talentierter Geschichtenerzähler. Die Fülle an Daten, die im vortrainierten dahinterliegenden Sprachmodell bereitstehen, sind gewaltig und die Geschwindigkeit, in der es Text generieren kann, bereits heute unglaublich hoch.

Nicht empfehlen kann ich einen Einsatz von ChatGPT bei notenrelevanten studentischen Arbeiten im Umfeld von engagierten Dozenten. 😂

Nach prädiktiver Analyse fand ich folgende Faustregel:

Szenario 1: selber schreiben

- bei 80% erwartetem Input gibt es mit hoher Wahrscheinlichkeit eine genügende Note

- bei 140% erwartetem Input gibt es mit hoher Wahrscheinlichkeit eine extraordinäre Note

Szenario 2: ChatGPT schreiben lassen, ohne es zu deklarieren

- bei 20% Input folgt die Vorhersagekraft eines Würfelwurfs …

(von 1 «DozentIn merkt» bis 6 «DozentIn merkt nicht»)

Szenario 3: ChatGPT wo sinnvoll unterstützend dazunehmen und klar deklarieren

- Zeitersparnis durch schnellere Ideation

- Zeitzuschlag durch zusätzliche Endkontrolle

Experimente mit ChatGPT deklarieren und bedenken, dass ihr allein für die korrekten Inhalte geradestehen müsst.

Viel Spass mit ChatGTP

Thomas Frehner